高逼真合成數(shù)據(jù)助力智駕“看得更準(zhǔn),、學(xué)得更快”

一,、引言

隨著自動駕駛技術(shù)的逐步落地,,感知系統(tǒng)對數(shù)據(jù)的依賴正快速增長,。傳統(tǒng)實車采集雖然真實可信,但在效率,、安全性,、標(biāo)注精度以及邊緣場景覆蓋方面均存在顯著限制。

合成數(shù)據(jù)(Synthetic Data)因具備低成本,、高可控性,、無限擴(kuò)展性和高精度標(biāo)簽等優(yōu)勢,已成為感知算法訓(xùn)練與驗證的重要數(shù)據(jù)來源,。尤其在多模態(tài),、多場景、大規(guī)模自動化生成等方面,,仿真平臺正成為構(gòu)建感知數(shù)據(jù)體系的重要工具,。

在感知系統(tǒng)的開發(fā)過程中,我們依托仿真平臺生成覆蓋多種場景和傳感器類型的合成數(shù)據(jù),,用于支持AVM(環(huán)視系統(tǒng))開發(fā),,同時也利用合成數(shù)據(jù)生成符合公開格式標(biāo)準(zhǔn)的數(shù)據(jù)集,助力算法在真實部署前實現(xiàn)高效迭代與驗證,。本文將系統(tǒng)介紹利用合成數(shù)據(jù)開發(fā)的具體應(yīng)用流程和實踐效果,。

二、 AVM系統(tǒng)開發(fā)中的仿真驗證應(yīng)用

環(huán)視系統(tǒng)(AVM, Around View Monitor)是自動駕駛和高級輔助駕駛系統(tǒng)(ADAS)中常見的功能模塊,,通常由4個或更多廣角魚眼相機(jī)構(gòu)成,,通過拼接多個攝像頭圖像生成車輛周圍360°的鳥瞰圖。

自動泊車系統(tǒng)(APA)需要環(huán)視圖像提供對車輛周圍環(huán)境的精準(zhǔn)感知,。通過仿真方式模擬魚眼相機(jī)布設(shè)和 BEV 拼接,,可生成多種泊車場景下的高保真圖像,包括地庫,、斜列車位,、窄通道等復(fù)雜工況。相比實車采集,仿真不僅可以批量構(gòu)造邊緣泊車條件,,還能自動提供精確的障礙物位置與車輛姿態(tài)標(biāo)注,,大幅加速感知模型的訓(xùn)練和驗證流程,減少實車調(diào)試時間,。

傳統(tǒng) AVM 系統(tǒng)的相機(jī)標(biāo)定依賴人工操作和實車設(shè)備,,流程繁瑣且精度受限。通過仿真,,可控制各攝像頭位置與視角,,并生成可重復(fù)、可驗證的圖像和標(biāo)定數(shù)據(jù),,適用于整車項目開發(fā)初期的快速迭代,。虛擬標(biāo)定不僅提高了標(biāo)定效率,還支持在方案切換,、批量測試,、相機(jī)布局驗證等場景中自動生成對齊標(biāo)注,降低人力投入,,提升系統(tǒng)上線速度,。

在實際開發(fā)中,AVM對圖像畸變建模,、拼接精度、投影映射等有較高要求,,傳統(tǒng)方法依賴人工標(biāo)定與測試,,周期長、靈活性差,。而基于aiSim的仿真流程,,可有效提升開發(fā)效率與驗證精度。

通過合成數(shù)據(jù)仿真平臺,,我們借助從環(huán)境搭建到數(shù)據(jù)生成的全流程仿真,成功實現(xiàn)了4個魚眼相機(jī)生成AVM合成數(shù)據(jù)的優(yōu)化和驗證,。

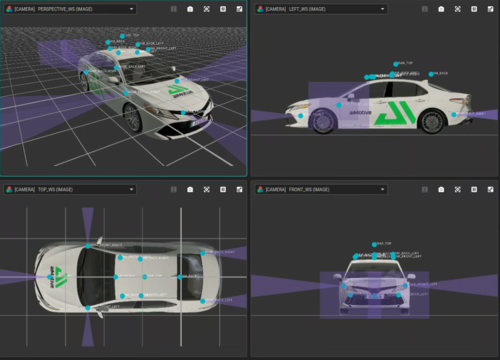

圖1 基于aiSim構(gòu)建AVM圖像流程

1、標(biāo)定地圖與仿真環(huán)境構(gòu)建

我們在Unreal Engine環(huán)境中快速搭建6米×11米標(biāo)定區(qū)域,,使用2×2黑白相間標(biāo)定板構(gòu)成特征紋理區(qū)域,,并精確布設(shè)車輛初始位置,確保視野重疊區(qū)域滿足投影需求,,并通過特定插件將其無縫導(dǎo)入仿真器中,。

圖2 基于aiSim插件的Unreal Engine地圖編輯

2,、魚眼相機(jī)配置與參數(shù)設(shè)置

設(shè)置前,、后,、左、右四個魚眼相機(jī),,分別具備:

(1)高水平FOV(約180°);

(2)不同俯仰角(前15°,、后25°、側(cè)向40°),;

(3)安裝位置貼近真實車輛安裝場景(如后視鏡下方),。

我們采用了仿真器內(nèi)置的OpenCV標(biāo)準(zhǔn)內(nèi)參建模,,輸出圖像同步生成物體的2D/3D邊界框與語義標(biāo)簽。

圖3 環(huán)視OpenCV魚眼相機(jī)傳感器配置

3、BEV圖像生成與AVM拼接

利用已知相機(jī)內(nèi)參和標(biāo)定區(qū)域結(jié)構(gòu),,通過OpenCV完成圖像去畸變與投影矩陣求解,,逐方向生成BEV視圖(Bird's Eye View)。結(jié)合車輛圖層與坐標(biāo)對齊規(guī)則,,拼接生成完整的AVM圖像,。

支持配置圖像分辨率(如1cm2/像素)與投影視野范圍,確保幾何準(zhǔn)確性,。

圖4 投影區(qū)域及BEV轉(zhuǎn)化示意圖

4、多場景合成與傳感器布局優(yōu)化

通過批量仿真腳本,,可快速測試不同環(huán)境(如夜間、窄巷,、地庫),、不同相機(jī)布局組合對AVM系統(tǒng)效果的影響。在算法不變的前提下,,系統(tǒng)性評估外參配置的優(yōu)劣,,為傳感器部署提供數(shù)據(jù)支持。

圖5 不同場景下的AVM合成數(shù)據(jù)

三,、合成數(shù)據(jù)構(gòu)建多模態(tài)數(shù)據(jù)集

隨著智能駕駛逐步從基礎(chǔ)輔助走向復(fù)雜場景下的高階功能,對感知系統(tǒng)的數(shù)據(jù)需求也在迅速升級。不僅需要覆蓋高速,、城區(qū),、出入口等典型 NOA 場景,還要求在不同模態(tài)之間實現(xiàn)精確對齊,,以支撐融合感知模型的訓(xùn)練與驗證,。在這類任務(wù)中,仿真生成的合成數(shù)據(jù)具備可控性強(qiáng),、標(biāo)簽精準(zhǔn),、格式標(biāo)準(zhǔn)的優(yōu)勢,正在成為算法開發(fā)的重要支撐手段,。

在智能領(lǐng)航輔助(NOA)場景中,,系統(tǒng)需識別高速匝道、變道車輛,、道路邊緣等要素,,對訓(xùn)練數(shù)據(jù)多樣性與標(biāo)注精度要求很高。通過仿真構(gòu)建城市快速路,、高速公路等多類 NOA 場景,,配合光照、天氣,、車流密度等變量自動生成圖像與多模態(tài)同步數(shù)據(jù),。這類合成數(shù)據(jù)可用于訓(xùn)練檢測、分割,、追蹤等模型模塊,,特別適合用于填補(bǔ)實車采集難以覆蓋的復(fù)雜或高風(fēng)險場景,增強(qiáng)模型魯棒性,。

融合感知模型依賴相機(jī)、毫米波雷達(dá),、激光雷達(dá)等多種傳感器協(xié)同輸入,,對數(shù)據(jù)的同步性和一致性要求較高。通過仿真,,可以同時生成這三類傳感器的視角數(shù)據(jù),,并自動對齊時間戳、坐標(biāo)系和標(biāo)注信息,,輸出包括 3D 邊界框,、語義分割、目標(biāo)速度等在內(nèi)的完整標(biāo)簽,,且格式兼容 nuScenes 等主流標(biāo)準(zhǔn),。這類數(shù)據(jù)可用于訓(xùn)練融合模型識別道路上的異形障礙物,例如夜間難以通過視覺識別的散落雜物,或需要多模態(tài)補(bǔ)強(qiáng)感知的邊緣目標(biāo),。仿真帶來的高度可控性也便于統(tǒng)一測試條件,,對模型性能進(jìn)行定量分析與精細(xì)化調(diào)優(yōu)。

在實際項目中,,合成數(shù)據(jù)的價值不僅體現(xiàn)在生成效率和標(biāo)注精度,,更在于其能否與下游算法開發(fā)流程無縫銜接。為了實現(xiàn)這一目標(biāo),,我們將 aiSim 導(dǎo)出的多模態(tài)原始數(shù)據(jù),,通過自研數(shù)據(jù)處理腳本,轉(zhuǎn)換為基本符合 nuScenes 標(biāo)準(zhǔn)格式的數(shù)據(jù)集,。

數(shù)據(jù)構(gòu)建流程如下:

1,、編寫符合 nuScenes 規(guī)范的傳感器配置文件

首先,我們根據(jù) nuScenes 的數(shù)據(jù)結(jié)構(gòu)要求,,定義并生成了包含相機(jī),、雷達(dá)、激光雷達(dá)等傳感器的配置文件,,包括傳感器類型,、安裝位置、外參信息等,。該步驟確保生成數(shù)據(jù)可直接映射至 nuScenes 的 calibrated_sensor.json 和 sensor.json,。

圖6 激光雷達(dá)部分的傳感器配置文件

圖7 符合nuScenes格式的傳感器配置

2,、利用 aiSim Stepped 模式導(dǎo)出對齊的原始數(shù)據(jù)

其次,在仿真階段,,我們啟用了仿真器的 Stepped Simulation 模式,,該模式支持以固定時間步長(如每 0.1 秒)推進(jìn)仿真,并確保所有傳感器在同一時間戳輸出數(shù)據(jù),。這種方式實現(xiàn)了多模態(tài)數(shù)據(jù)的時間戳全局對齊,,滿足 nuScenes 對數(shù)據(jù)同步的要求。

圖8 aiSim相機(jī)傳感器Bounding Box真值輸出

然后,,在仿真運行中,我們導(dǎo)出包含圖像,、點云,、雷達(dá)、Ego Pose,、2D/3D 標(biāo)注等原始數(shù)據(jù),,場景長度約為 20 秒,,覆蓋了一段在高流量城市交通中經(jīng)過十字路口的場景,作為構(gòu)建示例數(shù)據(jù)集的基礎(chǔ),。

3,、結(jié)構(gòu)化轉(zhuǎn)換為 nuScenes JSON 格式

此外,使用自研轉(zhuǎn)換腳本,,我們將導(dǎo)出的原始數(shù)據(jù)組織并填充為 nuScenes 所需的各類 JSON 文件,,并和標(biāo)準(zhǔn)格式對齊,包括:

scene.json:記錄場景序列,;

sample.json:定義幀級時間結(jié)構(gòu),;

sample_data.json:圖像、雷達(dá),、點云等數(shù)據(jù)路徑與時間戳,;

calibrated_sensor.json 和 sensor.json:傳感器類型及配置;

ego_pose.json:車輛軌跡,;

sample_annotation.json:3D 邊界框,、類別、屬性,;

instance.json,、category.json、visibility.json 等其他語義層級數(shù)據(jù),。

圖9 nuScenes 標(biāo)準(zhǔn)數(shù)據(jù)集JSON結(jié)構(gòu)表

4、數(shù)據(jù)集結(jié)構(gòu)搭建完成

最終,,構(gòu)建完成的數(shù)據(jù)集具備完整的時空同步結(jié)構(gòu)與語義標(biāo)簽,,可直接用于視覺感知、雷達(dá)檢測,、融合感知等模型訓(xùn)練與評估任務(wù),。該流程驗證了合成數(shù)據(jù)向標(biāo)準(zhǔn)訓(xùn)練數(shù)據(jù)的轉(zhuǎn)換路徑,并具備可擴(kuò)展性,,適用于更大規(guī)模的批量數(shù)據(jù)生成,。

圖10 激光雷達(dá)點云 + 相機(jī)融合標(biāo)注框

圖11 激光雷達(dá)點云 + 同類型標(biāo)注框 (俯視/側(cè)視)

這一完整流程不僅驗證了合成數(shù)據(jù)在工程流程中的落地能力,也為后續(xù)基于大規(guī)模仿真生成標(biāo)準(zhǔn)訓(xùn)練集打下了結(jié)構(gòu)基礎(chǔ),。

四,、aiSim:感知研發(fā)全流程平臺

在自動駕駛感知系統(tǒng)的開發(fā)過程中,仿真平臺已逐漸發(fā)展為合成數(shù)據(jù)生產(chǎn)的重要基礎(chǔ)設(shè)施,。aiSim 通過集成環(huán)境建模,、傳感器仿真,、多模態(tài)數(shù)據(jù)輸出與標(biāo)準(zhǔn)格式轉(zhuǎn)換等功能,支持從場景構(gòu)建到數(shù)據(jù)集生成的完整流程,。

1,、多樣場景與數(shù)據(jù)格式的靈活支持

aiSim 可精細(xì)還原環(huán)視系統(tǒng)中魚眼相機(jī)的安裝布局、圖像畸變特性及 BEV 視角拼接邏輯,,生成貼近實車采集的高保真圖像,。同時,平臺有一套自成體系的仿真數(shù)據(jù)組織與輸出機(jī)制,,涵蓋視覺,、激光雷達(dá)、毫米波雷達(dá)等多類型傳感器數(shù)據(jù)及真值標(biāo)注,。支持通過腳本調(diào)度自動批量生成不同氣候,、光照、地形和交通條件下的多樣化場景,,滿足大規(guī)模訓(xùn)練與邊緣場景驗證的需求,。

2、從物理建模到標(biāo)簽輸出的完整鏈條

借助圖形引擎,,aiSim 實現(xiàn)了對真實物理光照,、材質(zhì)、陰影和天氣的動態(tài)建模,。平臺支持相機(jī),、激光雷達(dá)、毫米波雷達(dá)等傳感器的物理與幾何特性建模,,兼容 OpenCV,、ROS 等常見開發(fā)標(biāo)準(zhǔn)。在數(shù)據(jù)輸出方面,,aiSim 支持多傳感器同步控制,,可自動生成對齊的 2D/3D 檢測框、語義標(biāo)簽,、Ego 軌跡等數(shù)據(jù),,覆蓋感知算法訓(xùn)練常見需求,減少數(shù)據(jù)清洗與后處理工作量,。

3,、工程集成與可擴(kuò)展性

aiSim 提供圖形界面、工具鏈與開放 API,,方便用戶將其集成至企業(yè)現(xiàn)有的數(shù)據(jù)平臺和模型訓(xùn)練流程中,。平臺內(nèi)的場景配置與資源系統(tǒng)具備良好的可擴(kuò)展性,支持用戶自定義傳感器布設(shè),、交通要素和場景資產(chǎn),,用于支持環(huán)視系統(tǒng),、感知模型、融合算法等不同研發(fā)階段的需求,。

無論是環(huán)視系統(tǒng)的泊車能力與虛擬標(biāo)定,,還是面向 NOA 和多模態(tài)融合的訓(xùn)練任務(wù),仿真生成的數(shù)據(jù)都在感知系統(tǒng)的實際落地中提供了可衡量,、可擴(kuò)展的價值,。讓數(shù)據(jù)獲取從“拍”到“造”,從“靠人”到“自動”,,為智能駕駛研發(fā)提速,、降本、增穩(wěn),。

相關(guān)產(chǎn)品

免責(zé)聲明

- 凡本網(wǎng)注明“來源:化工儀器網(wǎng)”的所有作品,,均為浙江興旺寶明通網(wǎng)絡(luò)有限公司-化工儀器網(wǎng)合法擁有版權(quán)或有權(quán)使用的作品,未經(jīng)本網(wǎng)授權(quán)不得轉(zhuǎn)載,、摘編或利用其它方式使用上述作品,。已經(jīng)本網(wǎng)授權(quán)使用作品的,應(yīng)在授權(quán)范圍內(nèi)使用,,并注明“來源:化工儀器網(wǎng)”,。違反上述聲明者,本網(wǎng)將追究其相關(guān)法律責(zé)任,。

- 本網(wǎng)轉(zhuǎn)載并注明自其他來源(非化工儀器網(wǎng))的作品,,目的在于傳遞更多信息,并不代表本網(wǎng)贊同其觀點和對其真實性負(fù)責(zé),,不承擔(dān)此類作品侵權(quán)行為的直接責(zé)任及連帶責(zé)任,。其他媒體、網(wǎng)站或個人從本網(wǎng)轉(zhuǎn)載時,,必須保留本網(wǎng)注明的作品第一來源,,并自負(fù)版權(quán)等法律責(zé)任。

- 如涉及作品內(nèi)容,、版權(quán)等問題,,請在作品發(fā)表之日起一周內(nèi)與本網(wǎng)聯(lián)系,否則視為放棄相關(guān)權(quán)利,。

手機(jī)版

手機(jī)版 化工儀器網(wǎng)手機(jī)版

化工儀器網(wǎng)手機(jī)版

化工儀器網(wǎng)小程序

化工儀器網(wǎng)小程序

官方微信

官方微信 公眾號:chem17

公眾號:chem17

掃碼關(guān)注視頻號

掃碼關(guān)注視頻號

采購中心

采購中心