目錄:北京津發(fā)科技股份有限公司>>行為表情與動作>> ErgoLABFACS人臉表情分析系統(tǒng)

| 產地類別 | 國產 | 應用領域 | 道路/軌道/船舶,航空航天,汽車及零部件,綜合 |

|---|

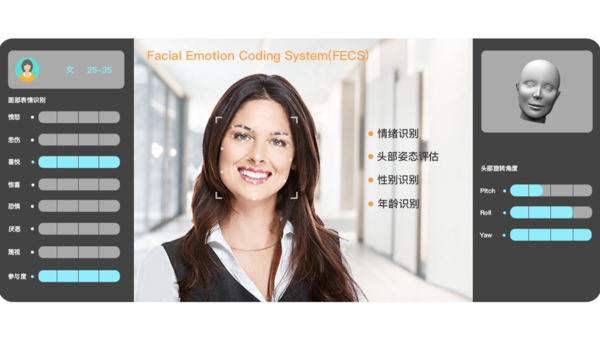

ErgoLAB面部表情分析系統(tǒng)產品概述

ErgoLAB FACS面部表情分析系統(tǒng)是主要的神經(jīng)行為測試工具之一,,該系統(tǒng)是一款專業(yè)的工具軟件,可自動分析面部表情和面部微表情動作,,同時系統(tǒng)內嵌情感效價識別模型,,直接測量個體的“消極”、“中性”,、“積極”的情感狀態(tài),,還提供視線方向、頭部朝向,、個人特征等數(shù)據(jù),。系統(tǒng)通過面部動作編碼體系(FACS:Facial Action Coding System)將許多現(xiàn)實生活中人類的表情進行了分類,是如今面部表情的肌肉運動的參照標準,。系統(tǒng)具備情緒狀態(tài)識別,、面部表情分析等功能,根據(jù)人臉的解剖學特點,,將其劃分成若干既相互獨立又相互聯(lián)系的運動單元(AU),,并分析了這些運動單元的運動特征及其所控制的主要區(qū)域以及與之相關的表情。

ErgoLAB FACS系統(tǒng)是*自主研發(fā)技術,,具有多項國家發(fā)明與軟件著作權,,通過了省部級新技術新產品認證,歐洲CE、美國FCC,、歐盟Rohs,、ISO9001、ISO14001,、OHSAS18001等多項管理體系認證,。廣泛應用于心理與行為觀察、人因智能與人機互動,、人機界面設計與產品可用性測試,、產品(廣告)營銷、汽車駕駛(交通安全),、工業(yè)管理,、工業(yè)設計、人因工程,、消費行為學,、應急行為研究、安全科學,、環(huán)境行為學,、建筑設計等多個領域科學研究。

ErgoLAB FACS面部表情分析系統(tǒng)是一款專業(yè)的面部表情分析與情緒狀態(tài)識別科研工具,。系統(tǒng)通過圖像識別技術結合機器學習等人工智能算法,,利用面部肌肉特征點計算和分類表情狀態(tài),自動編碼多種基本表情,、精確計算情感效價,;并通過龐大的數(shù)據(jù)庫使得模型預測的情緒準確率高達 93.3%。通過計算多維度數(shù)據(jù)特征,,結合AI狀態(tài)識別進一步研發(fā)可實現(xiàn)對操作人員的分心,、疲勞、應激等狀態(tài)的自動識別以及特定環(huán)境條件下的預警反饋,。ErgoLAB FACS系統(tǒng)采用*表情識別算法,,開發(fā)團隊在軟件功能及算法定制開發(fā)上積累了豐富的開發(fā)實施經(jīng)驗,可以根據(jù)用戶要求對軟件進行定制化設計開發(fā),,確保滿足用戶科研需要,。

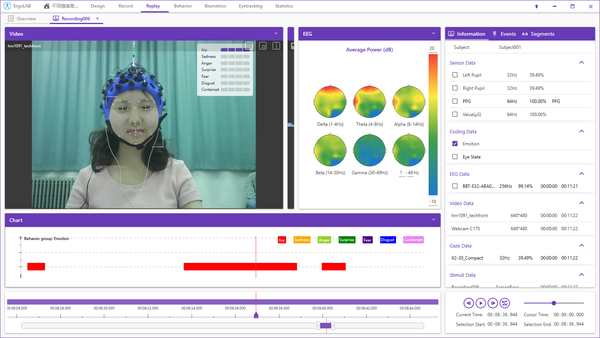

系統(tǒng)可以嵌入ErgoLAB行為觀察分析系統(tǒng)和人機環(huán)境同步平臺,支持在同一個軟件界面同步采集與分析多維數(shù)據(jù)源,,包括行為觀察視頻,、生理數(shù)據(jù)、眼動數(shù)據(jù),、腦電數(shù)據(jù),、動作捕捉,、生物力學、作業(yè)環(huán)境數(shù)據(jù)等,,包含多終端API/TTL實時行為編碼與事件標記應用程序,,并提供開放數(shù)據(jù)同步接口可供二次開發(fā)。

隨著神經(jīng)行為科學的迅猛發(fā)展,,人們開始嘗試用神經(jīng)行為學工具來測試各種商業(yè)行為表現(xiàn),。主要集中應用在對消費者偏好和滿意度的測試,如消費者觀看廣告內容時的表情和購買意愿的關系,;消費者聞不同氣味的香水后的表情反應與對香水偏好的關系,;聽眾的表情與音樂喜好的關系等眾多研究領域。情感預測態(tài)度和行動針對視頻圖像中的每一幀,,F(xiàn)ACS提供面部表情的7種關鍵指標的詳實數(shù)據(jù),,以及6種面部特征統(tǒng)計數(shù)據(jù)。這些參數(shù)可以洞察人們的情緒狀態(tài),,并提高消費品、廣告,、媒體,、軟件的商業(yè)價值。

二,、產品特點

1,、面部表情自動編碼

● 面部表情自定義處理參數(shù)模塊,包括實時處理及離線處理,,如數(shù)據(jù)插值,、中值濾波、均值濾波等,,支持自定義程度閾值,、合并閾值、以及大腦加工時間,。

● 自動識別并編碼七種基本表情,,包括高興、悲傷,、厭惡,、恐懼、驚訝,、生氣,、參與度,以0至100%區(qū)間計算表情程度值,;

● 計算多種微表情數(shù)據(jù),,如抬起眉毛內角,、抬起眉毛外角、皺眉(降低眉毛),、上眼瞼上升,、臉頰提升、眼輪匝肌外圈收緊/內圈收緊,、皺鼻,、拉動上嘴唇向上運動、拉動人中部位的皮膚向上,、拉動嘴角傾斜向上,、急劇的嘴唇拉動、收緊嘴角,、拉動嘴角向下傾斜,、拉動下唇向下、推動下唇向上,、撅嘴,、嘴角拉伸、收緊雙唇向外翻,、眼睛擴大,、張嘴等。

2,、狀態(tài)識別與預警反饋

● 系統(tǒng)內嵌情感效價計算模型,,精確識別積極、中性,、消極情感,,客觀評價個體情緒狀態(tài),與多模態(tài)數(shù)據(jù)形成客觀有效的印證關系,;

● 系統(tǒng)可自動檢測操作人員的頭部位置三軸數(shù)據(jù):俯仰角,、偏航角、翻滾角,;系統(tǒng)能夠自動檢測實時跟蹤操作人員頭部朝向,,包括俯仰角、偏航角,、翻滾角,,并測定注視方向,計算瞳孔間距以及注意狀態(tài)檢測,;

● 結合人工智能與機器學習算法,,進一步實現(xiàn)對操作人員的分心、疲勞,、應激等狀態(tài)的自動識別以及特定環(huán)境條件下的預警反饋,。

3,、面部表情分析與統(tǒng)計屬性識別

● 實時可視化的表情編碼:系統(tǒng)實時計算操作人員的表情狀態(tài)與情緒效價,在實驗過程中,,主試可實時查看與監(jiān)測操作人員的表情程度與情緒變化,,并做出相應的任務調整與行為預警。

● 自動統(tǒng)計面部表情數(shù)據(jù):包括每種面部表情的開始時間,、結束時間,、首次發(fā)生的時間、總發(fā)生次數(shù),、頻率,、每次發(fā)生的時間、總的持續(xù)時間,、總的持續(xù)時間在全部觀察時間中所占的百分比,、短的持續(xù)時間、長的持續(xù)時間,、平均持續(xù)時間,、持續(xù)時間的標準差、持續(xù)時間間隔置信區(qū)間等數(shù)據(jù),。

● 自動檢測操作人員的整個面部特征點,,并輸出原始坐標X、Y,,以及視線位置,;

● 系統(tǒng)包含年齡分類器,,支持實時計算并識別多個年齡段狀態(tài),,可智能識別多種被試屬性信息,如性別,、是否佩戴眼鏡,。

4、多維度數(shù)據(jù)統(tǒng)計與二次開發(fā)

● 多維度數(shù)據(jù)交叉統(tǒng)計:系統(tǒng)支持面部表情數(shù)據(jù)與其他多模態(tài)數(shù)據(jù)(眼動,、腦電,、生理、動補,、行為等)的同步交叉分析,,多個數(shù)據(jù)源在同一平臺界面呈現(xiàn),在采集的同時間軸數(shù)據(jù)里選擇相應的時間片段,,可同步觀察和統(tǒng)計分析所有數(shù)據(jù)流之間的相關關系,;

● 具有API開發(fā)接口:面部表情原始數(shù)據(jù)與狀態(tài)分析結果可以被其他程序實時訪問,可使其它程序對被試者的情緒進行反饋,。

三,、應用領域

●心理學與神經(jīng)科學研究,;

●人因工程與工效學研究;

●人因智能與人機交互研究,;

●智能交通與駕駛行為研究,;

●建筑人居健康與環(huán)境行為研究;

●市場研究與消費者調研,;

●用戶體驗與交互研究,;

●教育研究;

●臨床研究,;

●嬰兒研究,;

●體育運動研究;

●沉浸式VR研究,;

ErgoLAB表情分析系統(tǒng)專為用戶的整合面部表情的軟件的應用,,頭部跟蹤的移動過程中的面部表情變化,并記錄相貌,、位置,、頭部旋轉、關鍵面部特征和面部表情變化,。能檢測關鍵面部特征如眼球角落,嘴角,鼻子的頂端的位置,。依據(jù)關鍵面部特征檢測可以量化面部表情的變化提取出臉紋理信息進行注釋面部坐標,可以用于面部表情的3D模型建立以及面部表性變化分析。

產品與解決方案類別:虛擬現(xiàn)實實驗室,、眼動儀,、近紅外腦成像儀、腦電儀/事件相關電位系統(tǒng),、多導生理儀/神經(jīng)電生理記錄系統(tǒng),、動作捕捉系統(tǒng)、心理行為同步系統(tǒng),、人機環(huán)境同步平臺,、面部表情分析系統(tǒng)、行為觀察分析系統(tǒng),、人因工程實驗系統(tǒng),、工效學分析系統(tǒng)、生物力學/表面肌電分析系統(tǒng)等,;人因工程實驗室,,人機交互實驗室、用戶體驗實驗室,、可用性測試實驗室,、人機工效實驗室 。